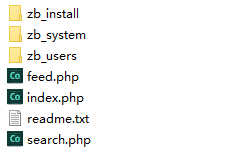

Z-Blog 博客创建设计robots.txt文件

robots.txt文件,相信大部分站长都知道其作用,通过它可以让搜索引擎蜘蛛不抓取网站的部分目录或文件。(需要提醒的是,网站的目录或文件并不是被抓取得越多越好)。使用Z-Blog 博客的博主很多忽略或者不知道怎么写robots文件,河南网站建设把自己使用的robots文件放出来供各博主参考下。

Z-Blog robots.txt文件:

以下是我的一个ZB博客使用的robots.txt文件。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 | #robots.txt for gmzhen #User-agent: * Disallow: /FUNCTION/ Disallow: /CACHE/ Disallow: /XML-RPC/ Disallow: /SCRIPT/ Disallow: /ADMIN/ Disallow: /CSS/ Disallow: /LANGUAGE/ Disallow: /DATA/ Disallow: /THEMES/ Disallow: /INCLUDE/ Disallow: /wap.asp Disallow: /cmd.asp Disallow: /c_option.asp Disallow: /c_custom.asp Sitemap: http://www.gmzhen.com/sitemap.xml |

本文链接:https://h.finchui.com/zblogcn/1452.html 转载需授权!

在线咨询

在线咨询